En informatique, Faire n’est pas compliqué.

C’est le Savoir-faire qui est long et difficile à acquérir.

La preuve ? Demandez à un informaticien de développer quelque chose qui va lui prendre disons 10 jours. Une fois le travail terminé, effacez tous les fichiers (on va plutôt dire que le serveur les a perdus et que la sauvegarde ne marchait pas…). Demandez-lui de recommencer. Eh bien, il le fera en 5 ou 6 jours tout au plus et le résultat sera meilleur que la première fois. Faire n’est donc pas compliqué.

En revanche, le coût d’acquisition des Savoir-faire informatiques a explosé ces dernières années avec la multiplication et la complexification des technologies.

Le bon vieux programme Basic des années 80 pour afficher des caractères sur un écran 80×24 n’est plus. Les programmes d’aujourd’hui sont incroyablement complexes : ils doivent fonctionner sur le Web comme sur mobile, pour des centaines d’utilisateurs, avec des performances et des fonctionnalités toujours plus riches. La diversité des compétences mises en œuvre explose littéralement. Qui maitrise aujourd’hui toutes les technologies et les savoir-faire nécessaires ? Si bien qu’à l’instar du bâtiment, le secteur informatique possède aujourd’hui ses corps de métier : ergonomes, graphistes, architectes, développeurs système ou réseau, algorithmiciens, développeurs Java ou C++ ou .Net ou PHP ou…

Et tout cela ne va guère en s’améliorant. Les environnements de développement et les plate-formes logicielles peinent à suivre le rythme et à réduire cette complexité. Si bien que dès qu’un projet implique un peu d’informatique, il faut mobiliser et inclure dans l’équipe des compétences technologiques fortes et seules des personnes ayant des compétences en programmation peuvent participer.

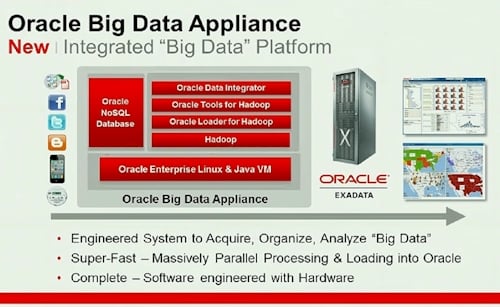

Prenons le cas du tout récent Big Data : certains, comme Harper Reed qui fut directeur technologique de la campagne électorale de Barack Obama, n’hésitent pas à dire que le Big Data c’est de « la connerie ». Sans aller jusque là, reconnaissons que le buzzword est désormais partout, et qu’il sert souvent d’alibi à des fournisseurs de matériel et de logiciel qui veulent renouveler à bon compte le marketing parfois essoufflé leurs offres. Pour autant, il y a de l’or à tirer des données des entreprises, pour peu qu’on sache les faire parler, les analyser, les valoriser et les consolider avec des données externes afin de les contextualiser. qui peut faire ça ? Les « Data Scientists » nous dit-on. Une race nouvelle, hybride, possédant des compétences en statistiques et en informatique, avec une sensibilité avancée pour les données et une compréhension des enjeux métier. Mais existent-t-ils vraiment ? Il semblerait que non à lire 01net Entreprises (« Il y a urgence à enseigner le Big Data !« ) ou ITPro (« Le Big Data freiné par une offre complexe et une pénurie de compétence« ).

Source : wikibook « Data Science: An introduction »

Source : wikibook « Data Science: An introduction »

Le fond du problème, c’est que les plateformes logicielles proposées sont trop complexes et exigent encore trop de mobiliser des compétences informatiques et techniques. Tout ça dans un contexte où les profils informatiques se font de plus en plus rares. Il faut arriver au point où la complexité technologique disparaît et où les solutions sont exploitables par des gens ayant avant tout des compétences métier et non des compétences technologiques. Un peu comme avec un iPhone : simple à utiliser et pourtant bourré d’innovation et de technologie.

C’est en ayant en tête ce contexte, et ces enjeux critiques d’agilité et de productivité, que nous concevons nos solutions logicielles chez Antidot.

Prenez l’exemple de notre solution d’analyse et d’intégration des données AIF – Information Factory : nous l’avons pensée et conçue de telle façon que vous pouvez construire des chaînes de traitement de données particulièrement avancées qui vont capter, nettoyer, sémantiser, classer, géotagger, enrichir, lier… des données sans nécessiter aucune connaissance en programmation.

Et notre plus grande fierté c’est de voir des projets incroyables réalisés par des gens du métier, sans compétence en développement.

Car finalement les meilleures technologies sont celles qui savent se faire oublier.